Meta und Microsoft kaufen neuen KI-Chip von AMD als Alternative zu Nvidia

- Meta, OpenAI und Microsoft sagten, sie würden den neuesten KI-Chip von AMD, den Instinct MI300X, verwenden – ein Zeichen dafür, dass Technologieunternehmen Alternativen zu teuren Nvidia-Grafikprozessoren suchen, die für KI unerlässlich waren.

- Wenn der MI300X gut genug und kostengünstig genug ist, wenn er Anfang nächsten Jahres auf den Markt kommt, könnte er die Kosten für die Entwicklung von KI-Modellen senken.

- Lisa Su, CEO von AMD, prognostizierte, dass der Markt für KI-Chips im Jahr 2027 400 Milliarden US-Dollar oder mehr erreichen wird, und sagte, sie hoffe, dass AMD einen erheblichen Teil dieses Marktes erobern werde.

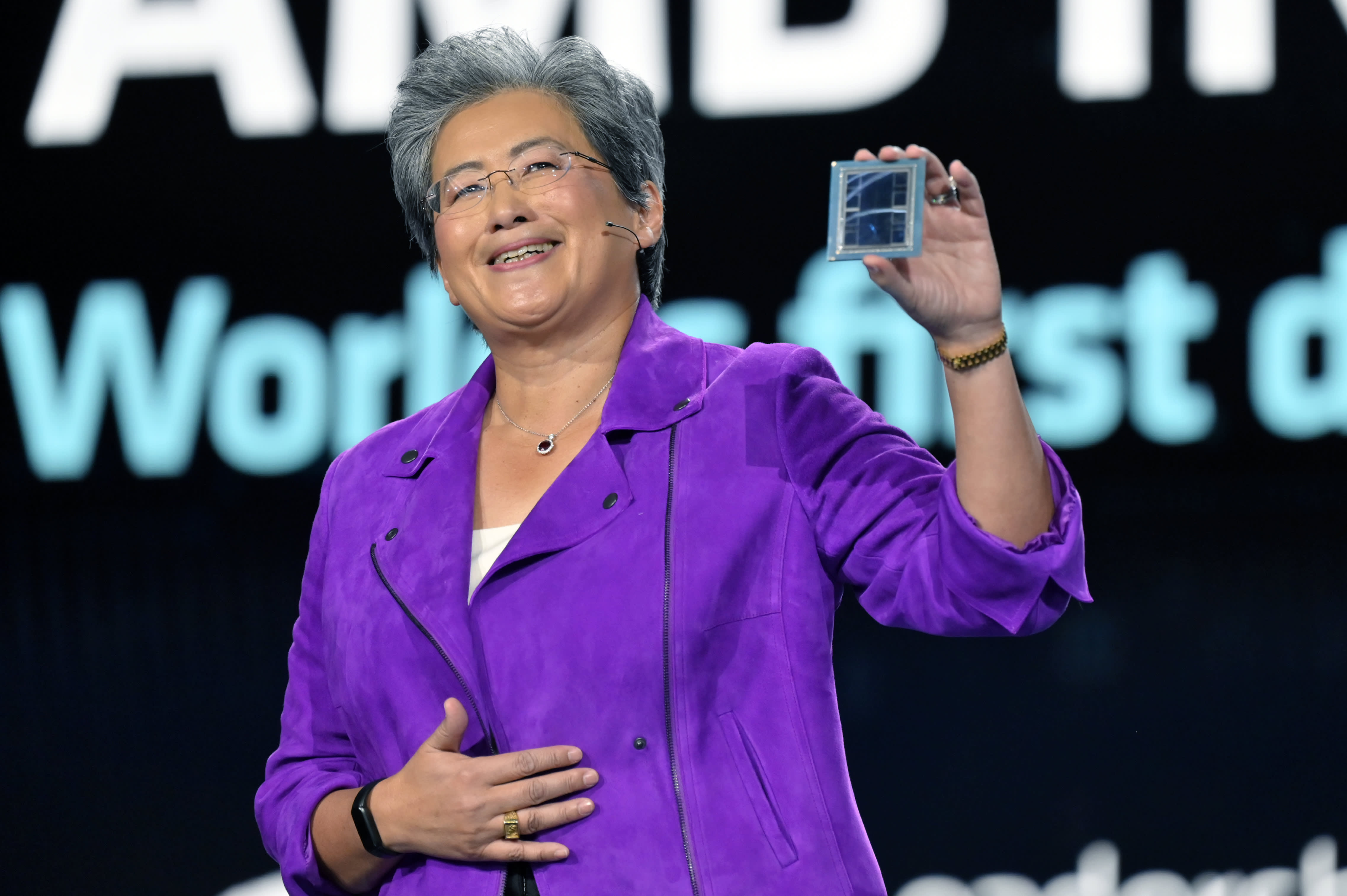

Lisa Su zeigt den AMD Instinct MI300 Chip während einer Keynote-Rede auf der CES 2023 in Las Vegas, Nevada, 4. Januar 2023.

David Becker | Getty Images

Meta, OpenAI und Microsoft gaben am Mittwoch auf einer AMD-Investorenveranstaltung bekannt, dass sie den neuesten KI-Chip von AMD, den Instinct MI300X, verwenden werden. Dies ist das bislang größte Anzeichen dafür, dass Technologieunternehmen nach Alternativen zu teuren Nvidia-Grafikprozessoren suchen, die für die Entwicklung und Bereitstellung von KI-Software wie ChatGPT von OpenAI benötigt werden.

Wenn die neuesten High-End-Chips von AMD gut genug für die Technologieunternehmen und Cloud-Anbieter sind, die KI-Modelle bauen und warten, wenn sie Anfang nächsten Jahres mit der Auslieferung beginnen, könnte dies die Entwicklungskosten für KI-Modelle senken und Wettbewerbsdruck auf Nvidias rasantes Umsatzwachstum bei KI-Chips ausüben. . .

„Die ganze Aufmerksamkeit gilt großer Hardware und großen GPUs für die Cloud“, sagte AMD-CEO Lisa Su am Mittwoch.

Laut AMD basiert der MI300X auf einer neuen Architektur, die häufig zu erheblichen Leistungssteigerungen führt. Das einzigartigste Merkmal ist, dass es über 192 GB eines fortschrittlichen Hochleistungsspeichertyps namens HBM3 verfügt, der Daten schneller überträgt und für größere KI-Modelle geeignet ist.

Su verglich den MI300X und die damit gebauten Systeme direkt mit Nvidias Flaggschiff-KI-GPU, dem H100.

„Diese Leistung führt direkt zu einer besseren Benutzererfahrung“, sagte Su. „Wenn Sie ein Model etwas fragen, möchten Sie, dass es schneller reagiert, insbesondere wenn die Antworten komplexer werden.“

Die Hauptfrage, mit der AMD konfrontiert ist, ist, ob Unternehmen, die sich bisher auf Nvidia verlassen haben, Zeit und Geld investieren werden, um einen weiteren GPU-Anbieter hinzuzufügen. „Die Einführung von AMD erfordert Arbeit“, sagte Su.

AMD teilte Investoren und Partnern am Mittwoch mit, dass es seine Software-Suite namens ROCm verbessert hat, um mit der branchenüblichen CUDA-Software von Nvidia zu konkurrieren. Damit wurde ein wesentlicher Nachteil behoben, der einer der Hauptgründe dafür war, dass KI-Entwickler derzeit Nvidia bevorzugen.

Auch der Preis wird wichtig sein. AMD hat am Mittwoch keine Preise für den MI300X bekannt gegeben, aber der Chip von Nvidia kann für einen einzelnen Chip etwa 40.000 US-Dollar kosten, und Su sagte Reportern, dass der Chip von AMD in der Anschaffung und im Betrieb weniger kosten müsste als der Chip von Nvidia, um Kunden zum Kauf zu bewegen .

AMD MI300X KI-Beschleuniger.

AMD gab am Mittwoch bekannt, dass es bereits einige GPU-hungrige Unternehmen für die Nutzung des Chips gewonnen hat. Meta und Microsoft waren laut Angaben im Jahr 2023 die größten Käufer von Nvidia H100-GPUs Ein aktueller Bericht des Forschungsunternehmens Omidia.

Meta sagte, es werde die MI300X-GPUs für KI-Inferenz-Workloads wie die Verarbeitung von KI-Bezeichnungen, die Bearbeitung von Bildern und die Ausführung seines Assistenten verwenden.

Kevin Scott, Chief Technology Officer von Microsoft, sagte, das Unternehmen werde über seinen Azure-Webdienst Zugriff auf die MI300X-Chips gewähren.

Oracle Cloud wird ebenfalls Chips verwenden.

OpenAI sagte, es werde AMD-GPUs in einem seiner Softwareprodukte namens Triton unterstützen, das kein so großes Sprachmodell wie GPT ist, aber in der KI-Forschung verwendet wird, um auf Chipfunktionen zuzugreifen.

AMD rechnet noch nicht mit großen Chipverkäufen und erwartet im Jahr 2024 nur etwa 2 Milliarden US-Dollar an GPU-Gesamtumsätzen für Rechenzentren. Nvidia meldete allein im letzten Quartal mehr als 14 Milliarden US-Dollar an Rechenzentrumsumsätzen, wobei diese Kennzahl auch andere Chipsätze als GPUs umfasst.

Allerdings geht AMD davon aus, dass der Gesamtmarkt für KI-GPUs in den nächsten vier Jahren auf 400 Milliarden US-Dollar anwachsen könnte, was eine Verdoppelung der bisherigen Prognose des Unternehmens darstellt. Dies zeigt, wie hoch die Erwartungen waren und wie begehrenswert hochmoderne KI-Chips geworden sind – und warum das Unternehmen nun die Aufmerksamkeit der Anleger auf die Produktlinie lenkt.

Su wies gegenüber Reportern auch darauf hin, dass AMD nicht glaubt, Nvidia schlagen zu müssen, um auf dem Markt erfolgreich zu sein.

„Ich denke, es ist klar zu sagen, dass Nvidia jetzt die überwiegende Mehrheit davon ausmachen sollte“, sagte Su gegenüber Reportern und bezog sich dabei auf den Markt für KI-Chips. „Wir glauben, dass es im Jahr 2027 mehr als 400 Milliarden US-Dollar erreichen könnte. Und wir können einen großen Teil davon bekommen.“

„Bier-Geek. Der böse Ninja der Popkultur. Kaffee-Stipendiat fürs Leben. Professioneller Internet-Lehrer. Fleisch-Lehrer.“

/cdn.vox-cdn.com/uploads/chorus_asset/file/24853119/IMG_3631.jpeg)